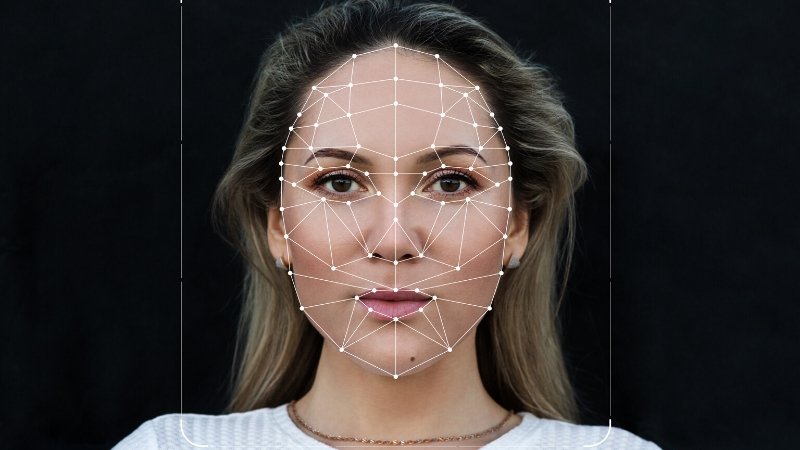

Pesquisadores alertam para o uso excessivo e fora de contexto do deepfake

A técnica de síntese de imagens ou sons humanos baseada em técnicas de inteligência artificial vem sendo cada vez mais usada comercialmente.

Temos notado que o deepfake tem crescido de forma rápida em áreas como educação, notícias e entretenimento, apesar das conotações negativas em torno do termo e o fato de as pessoas não quererem se associar a algo que seja “fake”. Na prática, é uma técnica que permite inserir o rosto de uma pessoa em fotos ou vídeos alterados por meio de inteligência artificial. Basta ter um vídeo da pessoa real como referência e o programa consegue modificá-lo. Já há várias opções de aplicativo para isso.

A Synthesia, uma companhia com sede em Londres, foi uma das primeiras da área técnica. Ela criou vídeos de treinamento corporativo com IA (inteligência artificial) para empresas, em parceria com o grupo de publicidade global WPP e a consultoria de negócios Accenture. Para criar um vídeo utilizando o sistema dessa empresa, é preciso apenas escolher um dos vários avatares, digitar o texto que você quer que seja dito e pronto, a mágica coorre, como se fosse quase um game.

Mas nesse terreno, nem tudo é brincadeira ou tem a função de treinamento empresarial. Uma ameaça comum nesse meio tem sido o chamado pornô de vingança, que pode ser um dos usos mais evidentes do deepfake. A Sensity (consultoria de segurança especializada em crimes usando IA) descobriu um robô no Telegram que recebia fotos de mulheres e as devolvia aos remetentes mostrando como elas ficariam nuas.

Outros exemplos, segundo a empresa, “são de ex-parceiros que criam vídeos pornográficos para se vingar e expor vítimas em clipes falsos; ou criminosos que usam a técnica para despir ou mostrar menores de idade em atos sexuais”, alerta a Sensity. Em outra situação, a pessoa recebe um vídeo de um parente, dizendo que está em perigo e que precisa de uma transferência de dinheiro urgente, por exemplo. Mas, na verdade, esse parente está são e salvo, na casa dele. Os golpistas apenas o recriaram digitalmente usando um deepfake.

Em agosto de 2019, um caso semelhante ocorreu com uma empresa de energia do Reino Unido. Ela sofreu um prejuízo de R$ 1,3 milhão em um golpe que envolveu um deepfake de um de seus diretores. E no pacote de riscos, há a possibilidade de criação de identidades virtuais falsas. Seria possível criar pessoas que nunca existiram para empregá-las como bots em redes sociais. Ou então para aplicar golpes e fraudes.

Em meio a tantos exemplos, o que se sabe é que disseminar desinformação para gerar fake news, utilizando a ferramenta tem sido corriqueiro para alguns. Daí, o usuário das redes sociais ou plataformas, ficar atento, não incorrer no erro de passar o conteúdo adiante; além de buscar, por meio de outros canais, tentar desmascarar a fraude, não tendo o material como verdadeiro.